추천 콘텐츠

인공지능이 전쟁의 모든 측면을 바꿔 놓고 있다

해군 항공기가 정글을 향해 급강하하면서 기체 덮개 아래로 한 무더기의 장비를 떨어뜨렸다. 일부 장비는 게릴라군의 발자국 소리나 군용 트럭의 점화 장치 작동을 감지하기 위한 마이크였다. 다른 것들은 지면의 미세한 진동을 파악하는 지진 탐지기였다. 가장 특이한 장비는 사람의 소변에서 암모니아 냄새를 맡을 수 있는 후각 감지기였다. 이 장비들에 탑재된 수많은 전기 부품들은 파악한 정보를 드론과 컴퓨터로 보냈다. 전투기들은 단 몇 분 만에 알고리즘이 지정한 격자 단위 지점에 융단 폭격을 시작했다. 1970년의 ‘이글루 화이트(Igloo White)’[1] 작전은 전쟁의 미래를 보여 줬다.

라오스에서 베트남으로 향하는 호치민을 막으려 했던 미국의 노력은 성공하지 못했다. 여기엔 연간 10억 달러(현재 가치로 환산하면 약 73억 달러)의 비용이 들었는데, 군용 트럭을 파괴하는 데만 10만 달러(현재 가치로 환산하면 73만 달러)가 소요됐다. 미국은 잠입 작전도 멈추지 않았다. 그러나 미국은 자동화 단계에 돌입한 전쟁의 매력에서 벗어나지 못했다. 감지기로 수집한 데이터를 그 어느 때보다 강력한 처리 능력으로 무장한 알고리즘으로 가공해, 적군보다 빠른 속도로 도출한 결과를 실행에 옮긴다는 아이디어는 세계 최강의 권력을 꿈꾸는 미국 군사 전략의 핵심이었다. 그리고 오늘날, 이러한 아이디어는 AI라는 새로운 기술의 발전으로 더욱 강력하게 뒷받침되고 있다.

미 국방부는 지난 2월 발표한 첫 AI 전략 문서에서 AI가 “미래 전쟁터의 성격을 바꿀 것”이라고 선언했다. 2018년 여름 출범시킨 합동 AI 센터(JAIC)와 AI 국가안전위원회(National Security Commission on AI)는 지난 3월 첫 미팅을 가졌다. 미 국방부는 2020년 AI 분야에 약 10억 달러(1조 1930억 원), AI 기술을 바탕으로 한 무인, 자동화 역량에는 AI 분야의 4배가 넘는 예산을 배정하고 있다.

어떤 기준으로 산정한 목표인지는 불분명하지만, 2030년까지 AI 분야에서 선두가 되고자 하는 중국에서도 비슷한 움직임이 나타나고 있다. 블라디미르 푸틴 대통령이 “이 영역에서 1등이 되는 국가가 세계를 지배할 것”이라고 예측한 러시아에서도 마찬가지다. 그러나 역설적인 것은 AI는 전쟁에 침투하는 동시에 전운을 짙어지게 만들고, 속도와 복잡성을 가중시킨다. 이는 인류에게는 본질적인 불투명성을 초래한다.

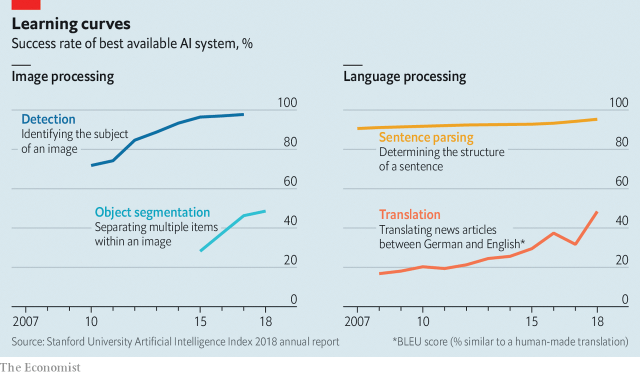

AI는 광범위하고 불분명한 용어다. 1950년대 태동기에 의미했던 규칙을 따르는 컴퓨터 시스템부터 컴퓨터가 스스로 수행해야 할 임무를 학습하는 머신러닝에 기초한 현대적 가능성까지 포함하고 있다. 특히 뇌에서 영감을 받은 신경망의 수많은 층으로 구성된, 가장 각광받고 있는 머신러닝 분야의 접근법인 딥러닝은 번역, 사물 인식, 게임까지 다양한 임무를 능숙하게 수행한다.(그림 참조) 펜실베이니아대 마이클 호로위츠(Michael Horowitz)는 AI를 내연 기관이나 전기에 비유한다. 무수하게 많은 형태의 응용이 가능한 활성화 기술이라는 의미다. 그는 군사 분야의 AI 적용 방법을 세 가지로 분류한다. 하나는 기계가 사람의 감독 없이 행동할 수 있는 형태다. 또 하나는 대규모 데이터를 처리하고 해석하는 것이다. 세 번째는 전쟁에 필요한 명령과 통제를 돕거나, 심지어 지휘하는 것이다.

라오스에서 베트남으로 향하는 호치민을 막으려 했던 미국의 노력은 성공하지 못했다. 여기엔 연간 10억 달러(현재 가치로 환산하면 약 73억 달러)의 비용이 들었는데, 군용 트럭을 파괴하는 데만 10만 달러(현재 가치로 환산하면 73만 달러)가 소요됐다. 미국은 잠입 작전도 멈추지 않았다. 그러나 미국은 자동화 단계에 돌입한 전쟁의 매력에서 벗어나지 못했다. 감지기로 수집한 데이터를 그 어느 때보다 강력한 처리 능력으로 무장한 알고리즘으로 가공해, 적군보다 빠른 속도로 도출한 결과를 실행에 옮긴다는 아이디어는 세계 최강의 권력을 꿈꾸는 미국 군사 전략의 핵심이었다. 그리고 오늘날, 이러한 아이디어는 AI라는 새로운 기술의 발전으로 더욱 강력하게 뒷받침되고 있다.

미 국방부는 지난 2월 발표한 첫 AI 전략 문서에서 AI가 “미래 전쟁터의 성격을 바꿀 것”이라고 선언했다. 2018년 여름 출범시킨 합동 AI 센터(JAIC)와 AI 국가안전위원회(National Security Commission on AI)는 지난 3월 첫 미팅을 가졌다. 미 국방부는 2020년 AI 분야에 약 10억 달러(1조 1930억 원), AI 기술을 바탕으로 한 무인, 자동화 역량에는 AI 분야의 4배가 넘는 예산을 배정하고 있다.

라이즈 오브 더 머신

어떤 기준으로 산정한 목표인지는 불분명하지만, 2030년까지 AI 분야에서 선두가 되고자 하는 중국에서도 비슷한 움직임이 나타나고 있다. 블라디미르 푸틴 대통령이 “이 영역에서 1등이 되는 국가가 세계를 지배할 것”이라고 예측한 러시아에서도 마찬가지다. 그러나 역설적인 것은 AI는 전쟁에 침투하는 동시에 전운을 짙어지게 만들고, 속도와 복잡성을 가중시킨다. 이는 인류에게는 본질적인 불투명성을 초래한다.

AI는 광범위하고 불분명한 용어다. 1950년대 태동기에 의미했던 규칙을 따르는 컴퓨터 시스템부터 컴퓨터가 스스로 수행해야 할 임무를 학습하는 머신러닝에 기초한 현대적 가능성까지 포함하고 있다. 특히 뇌에서 영감을 받은 신경망의 수많은 층으로 구성된, 가장 각광받고 있는 머신러닝 분야의 접근법인 딥러닝은 번역, 사물 인식, 게임까지 다양한 임무를 능숙하게 수행한다.(그림 참조) 펜실베이니아대 마이클 호로위츠(Michael Horowitz)는 AI를 내연 기관이나 전기에 비유한다. 무수하게 많은 형태의 응용이 가능한 활성화 기술이라는 의미다. 그는 군사 분야의 AI 적용 방법을 세 가지로 분류한다. 하나는 기계가 사람의 감독 없이 행동할 수 있는 형태다. 또 하나는 대규모 데이터를 처리하고 해석하는 것이다. 세 번째는 전쟁에 필요한 명령과 통제를 돕거나, 심지어 지휘하는 것이다.

전쟁터에서 시작해 보자. 자율성의 장점은 명백하다. 로봇은 사람에 비해 값이 싸고 더 단단하며, 쉽게 버릴 수 있다. 그러나 피 한 방울 흘리지 않고 전쟁터를 돌아다닐 로봇은 임무를 수행할 수 있을 정도로 지능이 높아야 한다. 지능이 낮은 드론은 전쟁에서 오랫동안 살아남을 수 없을 것이다. 심각한 문제는 또 있다. 총을 가지고 있는 우둔한 로봇은 전쟁 범죄를 일으킬 수도 있다. 따라서 AI는 기계의 기능에 적합한 기술을 제공할 수 있어야 한다. 여기에는 사물 인지나 방향 탐지 등 간단한 기술부터 다른 기계들과 협업하는 좀 더 고차원적 기술까지 포함된다.

이런 능력들을 갖춘 지능적인 기계는 한 사람이 할 수 없는 일들을 해낸다. 런던 킹스칼리지의 케네스 페인(Kenneth Payne)은 “AI 시스템은 이미 공대공 전투 시뮬레이션에서 숙련된 군 조종관을 능가하고 있다”고 말했다. 지난 2월 미 국방부 산하 방위고등연구계획국(DARPA·Defence Advanced Research Projects Agency)은 6대의 강력한 드론으로 실험을 했다. 드론들은 고도의 위협 상황은 물론 인간과의 접촉이 끊겼을 때에도 서로 협력해 임무를 수행했다.

그럼에도 불구하고 이런 시스템 대부분의 지능은 편협하고 불안정하다. 잘 정돈된 환경에서 하나의 임무를 완수하는 데는 능하지만 익숙하지 않은 환경에선 실패하기 쉽다. 결국 현존하는 자율 무기들은 레이더를 추격하는 미사일 주변을 맴돌거나, 선박과 전초 기지를 방어하는 속사포 사격을 하는 수준에 그치고 있다. 쓸모는 있지만, 그다지 혁신적이지 않은 이 무기들에는 최근 개발되고 있는 세련된 머신러닝 기술은 불필요하다.

AI가 전쟁터의 힘들고 단조로운 일을 하는 데만 유용할 것이라고 생각한다면 오산이다. 사람을 죽이든 죽이지 않든 로봇들은 확인한 결과에 따라 행동한다. 그러나 정찰기와 위성처럼 많은 군사 플랫폼에서 중요한 부분은 유용한 정보로 전환할 수 있는, 가공되지 않은 데이터를 송출하는 것이다. 현재 데이터의 양은 그 어느 때보다 많다. 가장 최신 자료인 2011년 한 해를 기준으로 하면 미국의 1만 1000대쯤 되는 드론은 32만 7000시간(약 37년)이 넘는 영상을 전송했다.

이런 정보들은 대부분 감시받지 않는다. 군사적 목적의 AI가 수행해야 할 두 번째 주요 임무는 데이터를 처리하는 일이다. 실험실에서 수행한 테스트 결과를 반영하는 스탠퍼드대학의 연례 AI 발전 지수에 따르면, 알고리즘은 화상 분류(image classification) 분야에서는 2015년에 인간의 성과를 능가했고, 2015년에서 2018년 사이엔 하나의 이미지에서 여러 사물을 찾아내는 좀 더 어려운 작업인 대상 분류(object segmentation) 분야에서 인간의 두 배에 가까운 성과를 냈다. 화상 정보를 처리하는 컴퓨터 비전(computer vision) 분야에서는 아직 인간 관찰자를 속이는 수준으로는 발전하지 못했다. 그러나 인간은 감지하지 못하지만 시스템은 인식할 수 있다. 한 연구는 0.04퍼센트의 픽셀을 바꾸는 것만으로 AI 시스템이 팬더 이미지를 긴팔원숭이로 인식하게 만들었다.

이러한 약점들에도 불구하고, 2017년 2월 미 국방부는 딥러닝 알고리즘이 “인간과 비슷한 수준의 기능을 수행할 수 있다”고 결론 내렸다. 국방부는 이후 ‘프로젝트 메이븐(Project Maven)’이라는 이름으로 알려진 ‘알고리즘 전투’ 팀을 꾸렸다. 딥러닝과 다른 기술을 이용해 의심스러운 대상과 행위를 식별해 내는 이 팀은 이슬람 국가(IS)와의 전쟁을 계기로 시작됐지만, 지금은 광범위하게 일하고 있다. 목표는 실행 가능한 정보를 생산하는 것이다. 이런 종류의 정보는 대부분 폭탄을 투하하거나 특수 부대가 문을 발로 차고 적진에 진입하는 데에 쓰인다.

프로젝트 메이븐에 대해 잘 알고 있는 한 내부 관계자는 시간 절약과 새로운 통찰의 측면에서 알고리즘 전투 팀이 분석가들에게 제공하는 유용성은 현재로선 미미한 수준이라고 말했다. 전체 도시 전경을 들여다볼 수 있는 광각 카메라가 숱한 긍정 오류(false positive·존재하지 않는 것을 존재하는 것으로 판단하는 오류)들을 쏟아 내고 있다는 것이 일례다. 그는 그러나 “이런 시스템의 본성은 고도의 반복 학습에 있다”고 그는 덧붙였다. 정보 처리 속도는 빠르고, 프로젝트 메이븐은 (AI 군사 전략에서) 빙산의 일각일 뿐이다.

영국 공군 소장으로 전역한 뒤 영국의 기업 ‘어스아이(Earth-i)’에서 일하고 있는 션 코베트(Sean Corbett)는 어스아이가 머신러닝 알고리즘을 적용해 위성으로 감지 가능한 거리에서 수십 곳의 군 기지에 배치된 각기 다른 군용기의 기종을 98퍼센트 이상의 정확도로 식별할 수 있다고 말했다. 그는 “가장 영리한 부분은 무엇이 정상이고 무엇이 비정상인지 자동으로 식별할 수 있는 방법을 개발하고 있다는 점”이라고 설명했다. 소프트웨어는 기지를 반복적으로 관찰하면서 일상적인 배치 상태와는 다른 불규칙한 움직임들을 구별해 낼 수 있게 된다. 명백한 변화가 나타난다면 정보 분석가들에게 보고된다.

물론 알고리즘은 어디에나 쓰일 수 있다. 이미지뿐 아니라 어떤 정보도 소화할 수 있다. 영국 정보 기관인 MI6의 국장인 알렉스 영거(Alex Younger) 경은 지난해 12월 “현대의 분석 기술과 결합한 방대한 데이터는 현대 사회를 투명하게 만들 것”이라고 말했다. 2012년 미국의 정보 기관인 국가안전보장국(NSA)에서 유출된 문서는 파키스탄의 휴대 전화 정보 수집에 활용된 (안전하게 ‘스카이넷’이라 불리는) 머신러닝 프로그램에 대해 설명하고 있다. 이 프로그램은 테러리스트 집단의 첩보원으로 일할 가능성이 있는 개인의 정보를 파악하기 위해 설치되었다. 예를 들어 휴대 전화 사용자가 지난달 파키스탄 동북부의 라호르(Lahore)에서 국경의 페샤와르(Peshawar)로 여행했는지, 평소보다 전화기를 더 자주 끄거나 교환했는지를 파악하는 것이다. 2016년까지 영국 합동군 사령관을 역임하고 전역한 리처드 배런(Richard Barrons) 경은 이렇게 말한다. “정보의 개념은 지휘관이 질문을 하면 정보 기관들이 답을 찾기 위해 수집한 정보들을 활용하는 과거의 세계에서 답을 찾기 어려운 새로운 세계로 전환되고 있다.”

실제로 질문에 답하는 데에 필요한 데이터가 적군으로부터 나오는 것만은 아니다. JAIC의 첫 프로젝트는 무기도 아니었고, 스파이 활동을 위한 도구도 아니었다. 그것은 블랙호크 헬기(다목적 전술 공수 작전 수행용 헬기)의 엔진 이상을 예측하기 위해 특수 부대와 협업하는 일이었다. 첫 번째 알고리즘 버전은 4월에 적용됐다. 지휘 통제 임무를 맡은 군용기와 수송 차량에 대한 공군의 실험 결과, 예측 정비(predictive maintenance) 등을 통해 계획되지 않은 업무의 양을 3분의 1 가까이 줄일 수 있었다. 이는 현재 국방부가 장비 유지에 투입하고 있는 예산 780억 달러(92조 9300억 원)를 크게 감축할 수 있다는 의미다.

물론 정보를 처리하는 일의 핵심 목적은 실제로 작전을 수행하는 것이다. 그리고 AI가 전쟁을 바꿀 세 번째 방법은 소대부터 전국 본부에 이르기까지 군사적인 의사 결정 과정에 서서히 침투하는 것이다. 이스라엘 AI 기업 유니콰이(Uniqai)가 개발한 ‘북방의 화살(Northern Arrow)’은 군 지휘관이 임무를 계획할 때 도움을 주는 시판 상품들 가운데 하나다. 북방의 화살은 적의 위치, 무기 종류, 지형, 그리고 날씨 등 각각의 변수에 따라 방대하게 수집되는 정보를 잘게 쪼개 준다. 원래는 군사들이 12~24시간 동안 지도와 차트를 세밀히 들여다보면서 수행해야 했던 작업이었다. 이 소프트웨어는 고도별 탱크의 속도 같은 정보를 도서와 매뉴얼, 그리고 경험 많은 지휘관들과의 인터뷰를 통해 수집하고 있다. 알고리즘은 우왕좌왕하는 의사 결정권자에게 왜 이러한 선택이 이뤄져야 하는지에 대한 설명과 함께 옵션을 제공한다.

북방의 화살이나 미국의 유사한 CADET(컴퓨터 보조 설계 및 평가) 소프트웨어 같은 ‘전문가 시스템’ 플랫폼들은 사람보다 훨씬 더 빠르게 일할 수 있다. CADET으로 2분 걸리는 일을 하려면 한 사람이 16시간 동안 일해야 한다는 연구 결과도 있다. 그러나 이런 작업들은 정해진 규칙에 따르는 기술들을 사용하는데, 알고리즘 측면에서는 비교적 간단한 기술이다. 역사적 기준으로 볼 때 이들은 AI로 간주되긴 하지만, 같은 입력 정보가 항상 같은 출력 정보를 도출하는 방법인 결정론적 방식을 쓴다. 이 방법은 세계 최초의 범용 컴퓨터인 에니악(ENIAC)이 도출한 출력 정보를 활용하던 군인들에게 익숙한 이야기다. 이 컴퓨터는 1945년 포병 사격표[2]를 개발했다.

실제 세계에서 무작위성은 정확한 예측에 방해가 된다. 그래서 수많은 현대적 AI 시스템은 보다 복잡한 계획을 실현하기 위한 디딤돌로서 정해진 규칙에 따르는 기존의 방식에 무작위성을 더한다. DARPA의 실시간 대립 지능과 의사 결정(RAID·Real-time Adversarial Intelligence and Decision-making) 소프트웨어는 5시간 뒤 적의 목표와 움직임, 심지어 감정까지 예측하는 것을 목표로 한다. 이 시스템은 큰 문제들을 작은 게임 단위로 축소해 문제 해결에 필요한 컴퓨터의 동력을 줄이는 일종의 게임 이론을 기반으로 삼고 있다.

2004년부터 2008년까지 실시된 초기 실험에서 RAID는 사람보다 더 훌륭한 정확성과 속도를 자랑했다. 바그다드에서 실시된 2시간의 시뮬레이션 게임은 사람으로 구성된 다수의 팀이 RAID 또는 사람들과 맞붙는 방식이었다. 사람으로 구성된 팀의 절반 이상은 어느 쪽이 사람이고 어느 쪽이 소프트웨어인지 인식하지 못했다. 소프트웨어 디자이너 중 한 명이었던 보리스 스틸먼(Boris Stilman)은 “이라크 반란군 역할을 맡은 퇴역 대령들이 소프트웨어에 겁을 먹어서 서로 대화를 하지 않고 손으로 신호를 주고받았다”고 회고했다. RAID는 이제 군용으로 개발되고 있다.

이런 능력들을 갖춘 지능적인 기계는 한 사람이 할 수 없는 일들을 해낸다. 런던 킹스칼리지의 케네스 페인(Kenneth Payne)은 “AI 시스템은 이미 공대공 전투 시뮬레이션에서 숙련된 군 조종관을 능가하고 있다”고 말했다. 지난 2월 미 국방부 산하 방위고등연구계획국(DARPA·Defence Advanced Research Projects Agency)은 6대의 강력한 드론으로 실험을 했다. 드론들은 고도의 위협 상황은 물론 인간과의 접촉이 끊겼을 때에도 서로 협력해 임무를 수행했다.

그럼에도 불구하고 이런 시스템 대부분의 지능은 편협하고 불안정하다. 잘 정돈된 환경에서 하나의 임무를 완수하는 데는 능하지만 익숙하지 않은 환경에선 실패하기 쉽다. 결국 현존하는 자율 무기들은 레이더를 추격하는 미사일 주변을 맴돌거나, 선박과 전초 기지를 방어하는 속사포 사격을 하는 수준에 그치고 있다. 쓸모는 있지만, 그다지 혁신적이지 않은 이 무기들에는 최근 개발되고 있는 세련된 머신러닝 기술은 불필요하다.

개선하고, 개선하고, 개선하라

AI가 전쟁터의 힘들고 단조로운 일을 하는 데만 유용할 것이라고 생각한다면 오산이다. 사람을 죽이든 죽이지 않든 로봇들은 확인한 결과에 따라 행동한다. 그러나 정찰기와 위성처럼 많은 군사 플랫폼에서 중요한 부분은 유용한 정보로 전환할 수 있는, 가공되지 않은 데이터를 송출하는 것이다. 현재 데이터의 양은 그 어느 때보다 많다. 가장 최신 자료인 2011년 한 해를 기준으로 하면 미국의 1만 1000대쯤 되는 드론은 32만 7000시간(약 37년)이 넘는 영상을 전송했다.

이런 정보들은 대부분 감시받지 않는다. 군사적 목적의 AI가 수행해야 할 두 번째 주요 임무는 데이터를 처리하는 일이다. 실험실에서 수행한 테스트 결과를 반영하는 스탠퍼드대학의 연례 AI 발전 지수에 따르면, 알고리즘은 화상 분류(image classification) 분야에서는 2015년에 인간의 성과를 능가했고, 2015년에서 2018년 사이엔 하나의 이미지에서 여러 사물을 찾아내는 좀 더 어려운 작업인 대상 분류(object segmentation) 분야에서 인간의 두 배에 가까운 성과를 냈다. 화상 정보를 처리하는 컴퓨터 비전(computer vision) 분야에서는 아직 인간 관찰자를 속이는 수준으로는 발전하지 못했다. 그러나 인간은 감지하지 못하지만 시스템은 인식할 수 있다. 한 연구는 0.04퍼센트의 픽셀을 바꾸는 것만으로 AI 시스템이 팬더 이미지를 긴팔원숭이로 인식하게 만들었다.

이러한 약점들에도 불구하고, 2017년 2월 미 국방부는 딥러닝 알고리즘이 “인간과 비슷한 수준의 기능을 수행할 수 있다”고 결론 내렸다. 국방부는 이후 ‘프로젝트 메이븐(Project Maven)’이라는 이름으로 알려진 ‘알고리즘 전투’ 팀을 꾸렸다. 딥러닝과 다른 기술을 이용해 의심스러운 대상과 행위를 식별해 내는 이 팀은 이슬람 국가(IS)와의 전쟁을 계기로 시작됐지만, 지금은 광범위하게 일하고 있다. 목표는 실행 가능한 정보를 생산하는 것이다. 이런 종류의 정보는 대부분 폭탄을 투하하거나 특수 부대가 문을 발로 차고 적진에 진입하는 데에 쓰인다.

프로젝트 메이븐에 대해 잘 알고 있는 한 내부 관계자는 시간 절약과 새로운 통찰의 측면에서 알고리즘 전투 팀이 분석가들에게 제공하는 유용성은 현재로선 미미한 수준이라고 말했다. 전체 도시 전경을 들여다볼 수 있는 광각 카메라가 숱한 긍정 오류(false positive·존재하지 않는 것을 존재하는 것으로 판단하는 오류)들을 쏟아 내고 있다는 것이 일례다. 그는 그러나 “이런 시스템의 본성은 고도의 반복 학습에 있다”고 그는 덧붙였다. 정보 처리 속도는 빠르고, 프로젝트 메이븐은 (AI 군사 전략에서) 빙산의 일각일 뿐이다.

영국 공군 소장으로 전역한 뒤 영국의 기업 ‘어스아이(Earth-i)’에서 일하고 있는 션 코베트(Sean Corbett)는 어스아이가 머신러닝 알고리즘을 적용해 위성으로 감지 가능한 거리에서 수십 곳의 군 기지에 배치된 각기 다른 군용기의 기종을 98퍼센트 이상의 정확도로 식별할 수 있다고 말했다. 그는 “가장 영리한 부분은 무엇이 정상이고 무엇이 비정상인지 자동으로 식별할 수 있는 방법을 개발하고 있다는 점”이라고 설명했다. 소프트웨어는 기지를 반복적으로 관찰하면서 일상적인 배치 상태와는 다른 불규칙한 움직임들을 구별해 낼 수 있게 된다. 명백한 변화가 나타난다면 정보 분석가들에게 보고된다.

물론 알고리즘은 어디에나 쓰일 수 있다. 이미지뿐 아니라 어떤 정보도 소화할 수 있다. 영국 정보 기관인 MI6의 국장인 알렉스 영거(Alex Younger) 경은 지난해 12월 “현대의 분석 기술과 결합한 방대한 데이터는 현대 사회를 투명하게 만들 것”이라고 말했다. 2012년 미국의 정보 기관인 국가안전보장국(NSA)에서 유출된 문서는 파키스탄의 휴대 전화 정보 수집에 활용된 (안전하게 ‘스카이넷’이라 불리는) 머신러닝 프로그램에 대해 설명하고 있다. 이 프로그램은 테러리스트 집단의 첩보원으로 일할 가능성이 있는 개인의 정보를 파악하기 위해 설치되었다. 예를 들어 휴대 전화 사용자가 지난달 파키스탄 동북부의 라호르(Lahore)에서 국경의 페샤와르(Peshawar)로 여행했는지, 평소보다 전화기를 더 자주 끄거나 교환했는지를 파악하는 것이다. 2016년까지 영국 합동군 사령관을 역임하고 전역한 리처드 배런(Richard Barrons) 경은 이렇게 말한다. “정보의 개념은 지휘관이 질문을 하면 정보 기관들이 답을 찾기 위해 수집한 정보들을 활용하는 과거의 세계에서 답을 찾기 어려운 새로운 세계로 전환되고 있다.”

실제로 질문에 답하는 데에 필요한 데이터가 적군으로부터 나오는 것만은 아니다. JAIC의 첫 프로젝트는 무기도 아니었고, 스파이 활동을 위한 도구도 아니었다. 그것은 블랙호크 헬기(다목적 전술 공수 작전 수행용 헬기)의 엔진 이상을 예측하기 위해 특수 부대와 협업하는 일이었다. 첫 번째 알고리즘 버전은 4월에 적용됐다. 지휘 통제 임무를 맡은 군용기와 수송 차량에 대한 공군의 실험 결과, 예측 정비(predictive maintenance) 등을 통해 계획되지 않은 업무의 양을 3분의 1 가까이 줄일 수 있었다. 이는 현재 국방부가 장비 유지에 투입하고 있는 예산 780억 달러(92조 9300억 원)를 크게 감축할 수 있다는 의미다.

AI의 쿠데타

물론 정보를 처리하는 일의 핵심 목적은 실제로 작전을 수행하는 것이다. 그리고 AI가 전쟁을 바꿀 세 번째 방법은 소대부터 전국 본부에 이르기까지 군사적인 의사 결정 과정에 서서히 침투하는 것이다. 이스라엘 AI 기업 유니콰이(Uniqai)가 개발한 ‘북방의 화살(Northern Arrow)’은 군 지휘관이 임무를 계획할 때 도움을 주는 시판 상품들 가운데 하나다. 북방의 화살은 적의 위치, 무기 종류, 지형, 그리고 날씨 등 각각의 변수에 따라 방대하게 수집되는 정보를 잘게 쪼개 준다. 원래는 군사들이 12~24시간 동안 지도와 차트를 세밀히 들여다보면서 수행해야 했던 작업이었다. 이 소프트웨어는 고도별 탱크의 속도 같은 정보를 도서와 매뉴얼, 그리고 경험 많은 지휘관들과의 인터뷰를 통해 수집하고 있다. 알고리즘은 우왕좌왕하는 의사 결정권자에게 왜 이러한 선택이 이뤄져야 하는지에 대한 설명과 함께 옵션을 제공한다.

북방의 화살이나 미국의 유사한 CADET(컴퓨터 보조 설계 및 평가) 소프트웨어 같은 ‘전문가 시스템’ 플랫폼들은 사람보다 훨씬 더 빠르게 일할 수 있다. CADET으로 2분 걸리는 일을 하려면 한 사람이 16시간 동안 일해야 한다는 연구 결과도 있다. 그러나 이런 작업들은 정해진 규칙에 따르는 기술들을 사용하는데, 알고리즘 측면에서는 비교적 간단한 기술이다. 역사적 기준으로 볼 때 이들은 AI로 간주되긴 하지만, 같은 입력 정보가 항상 같은 출력 정보를 도출하는 방법인 결정론적 방식을 쓴다. 이 방법은 세계 최초의 범용 컴퓨터인 에니악(ENIAC)이 도출한 출력 정보를 활용하던 군인들에게 익숙한 이야기다. 이 컴퓨터는 1945년 포병 사격표[2]를 개발했다.

실제 세계에서 무작위성은 정확한 예측에 방해가 된다. 그래서 수많은 현대적 AI 시스템은 보다 복잡한 계획을 실현하기 위한 디딤돌로서 정해진 규칙에 따르는 기존의 방식에 무작위성을 더한다. DARPA의 실시간 대립 지능과 의사 결정(RAID·Real-time Adversarial Intelligence and Decision-making) 소프트웨어는 5시간 뒤 적의 목표와 움직임, 심지어 감정까지 예측하는 것을 목표로 한다. 이 시스템은 큰 문제들을 작은 게임 단위로 축소해 문제 해결에 필요한 컴퓨터의 동력을 줄이는 일종의 게임 이론을 기반으로 삼고 있다.

2004년부터 2008년까지 실시된 초기 실험에서 RAID는 사람보다 더 훌륭한 정확성과 속도를 자랑했다. 바그다드에서 실시된 2시간의 시뮬레이션 게임은 사람으로 구성된 다수의 팀이 RAID 또는 사람들과 맞붙는 방식이었다. 사람으로 구성된 팀의 절반 이상은 어느 쪽이 사람이고 어느 쪽이 소프트웨어인지 인식하지 못했다. 소프트웨어 디자이너 중 한 명이었던 보리스 스틸먼(Boris Stilman)은 “이라크 반란군 역할을 맡은 퇴역 대령들이 소프트웨어에 겁을 먹어서 서로 대화를 하지 않고 손으로 신호를 주고받았다”고 회고했다. RAID는 이제 군용으로 개발되고 있다.

최근의 딥러닝 시스템은 가장 불가사의하다. 2016년 3월 구글의 딥마인드(DeepMind)가 개발한 딥러닝 알고리즘인 알파고(AlphaGo)는 고대 중국 전략 게임인 바둑에서 세계 최강자 중 하나인 이세돌을 무너뜨렸다. 경기 도중에 알파고는 고도로 창의적인 수를 둠으로써 전문가들을 혼란에 빠뜨렸다. 바로 다음 달 중국의 군사과학원은 이 경기가 주는 의미를 연구하기 위한 워크숍을 열었다. 중국의 군사 혁신 분야 전문가인 엘사 카니아(Elsa Kania) 박사는 “중국의 군사 전략가들이 염두에 두어야 할 알파고 승리의 교훈은 AI가 전쟁과 비교될 수 있는 게임에서 인간보다 더 우수한 전술과 책략을 만들어 낼 수 있다는 사실”이라고 말했다.

2018년 12월 딥마인드의 또 다른 프로그램 알파스타(AlphaStar)가 실시간으로 진행되는 비디오게임 스타크래프트II의 강력한 게이머를 격파했다. 바둑처럼 차례차례 진행되는 방식도 아니었고, 상대가 누구인지도 모르는 상태였다. 알파스타는 알파고보다 더 자유롭게 경기에 임했다. 많은 장교들은 이 같은 게임 수행 능력이 군대의 역사에서도 손에 꼽히는 유형의 독창적이고 정교한 군사 훈련으로 이어지기를 바라고 있다. 미 국방부의 상업용 기술 시험 부서인 방어 혁신 본부(the Defence Innovation Unit)의 마이클 브라운(Michael Brown) 국장은 AI가 투입되는 “전략적 추론”이 본부의 최우선 과제 중 하나라고 언급했다.

그러나 인간의 창의성을 뛰어넘은 알고리즘은 인간의 이해 범위를 벗어날 수도 있다. 그렇게 되면 법률, 도덕 그리고 신뢰와 관련된 문제가 생긴다. 전쟁 법률은 민간인 피해와 군사적 이득 사이의 비례 원칙이나 필요성 원칙 같은 개념에 대한 일련의 판단에 따른다. 왜 이 목표물이 선택됐는지 설명하지 못하는 소프트웨어는 법률을 준수하지 못할 것이다. 설사 준수했다 하더라도 사람들은 표면적으로는 ‘마법의 8번 공(질문에 대한 스무 가지 답을 무작위로 보여 주는 장난감)’처럼 보이는 의사 결정 보조 도구의 판단을 믿지 않을 것이다.

영국 공군 정보 사령관 키스 디어(Keith Dear)는 이렇게 묻는다. “AI가 군사 전략에 적용되고, 인간이 고려할 수 있는 작전의 범주를 넘어서서 다중적인 상호 작용에 따른 확률적인 추론을 제시할 때 우리는 어떻게 해야 할까?”, “인간이 이해하지 못하는 행동 방침을 제시한다면 어떻게 할 것인가?” 그는 AI가 루마니아 수도 몰도바에서 일어난 러시아의 군 급습에 대한 대응으로 아제르바이잔의 수도 바쿠에서 열리는 오페라에 후원금을 내라는 제안을 할 수도 있다고 설명했다. 이런 초현실적인 전략은 적군이 아니라 아군을 당황하게 만들 수 있다. AI의 이런 결정은 앞선 정치적 사건들을 바탕으로 도출된 것이지만, 지휘관들이 즉각적으로 받아들일 수 있는 전략은 아니다.

디어는 그러나, 인간이 불가해성과 효율성 사이의 거래를 받아들일 것이라고 전망했다. “오늘날의 기술적인 한계에도 불구하고 AI는 현실에 가까운 거대한 규모의 시뮬레이션을 거쳐 실제 전투의 의사 결정을 도울 겁니다. AI가 전투를 장악하지 않는다면 말이죠.”

말도 안 되는 얘기가 아니다. 리처드 배런 경은 영국 국방부가 이미 현실 세계의 복합적인 환경을 모방한 가상의 클라우드 기반 환경에서 기술을 시연할 수 있는 소프트웨어를 사들이고 있다고 전했다. 이 소프트웨어는 ‘포트나이트’와 같은 온라인 비디오게임을 거대한 스케일로 확대한 군사 버전 게임이라고 할 수 있다. 게임 회사인 임프로버블(Improbable)과 비행 시뮬레이터로 잘 알려진 CAE가 개발했는데, 개방형 표준을 사용하고 있어서 기밀 정보부터 실시간 날씨 데이터까지 모든 정보를 연결할 수 있다. 리처드 경은 방대한 데이터와 그것을 옮길 수 있는 네트워크, 데이터를 처리할 수 있는 클라우드 컴퓨팅이 존재하는 한 “이 소프트웨어는 명령과 통제가 이뤄지는 방식에 혁신을 일으킬 것”이라고 말했다. 새로운 시스템은 “NSC부터 실무 지휘관에 이르는 하나의 종합적인 명령 체계”를 가능하게 만들 것이다.

서구 국가들은 AI가 활용되더라도 사람이 기계를 감독하면서 핵심 역할을 할 것이라고 주장하고 있다. 그러나 해당 국가 정부의 관계자들조차 이런 생각에 동의하지 않는다. 디어 사령관은 “인간은 의사 결정 과정에 참여하지 않아 정보에서 배제되거나, 작전부터 전략까지 다양한 의사 결정을 하는 팀에서 축출될 가능성이 커 보인다”고 말했다. 중국 군사 전문가인 엘사 카니아 박사에 따르면, 중국 군사과학원 보고서에도 “전투는 인간의 인지 능력을 뛰어넘는 수준으로 빨라질 것”이라는 내용이 있다. 그 결과는 자율 무기뿐 아니라 자동화된 전쟁터에도 영향을 미칠 것이다. 전쟁의 초기 단계에서 상호 연결된 AI 시스템은 미사일 발사대, 항공 모함 등 목표물을 정하고, 가장 효율적인 순서로 파괴할 수 있는 빠르고 정확한 공격을 실행할 것이다.

이런 변화가 초래할 결과는 여전히 불투명하다. 로렌스 리버모어 국립 연구소의 재커리 데이비스(Zachary Davis) 박사는 빠르고 정확한 공격 가능성은 “기습의 위험에 대한 인지 수준을 높여 (힘의 균형에 의한) 안정성을 훼손할 수 있다”고 지적한다. 그러나 동시에 AI는 기습 공격의 신호를 감지해 공격을 피할 수 있도록 도와주는 역할도 할 수 있다. 반대로 1960년대 베트남 정글에 투입됐던 센서로 무장한 장비들처럼 비용은 비싸고 효과는 없는 실패한 계획이 될 수도 있다. 그럼에도 불구하고, 어떤 권력도 경쟁 세력보다 뒤처지는 위험을 원치 않는다. 그리고 이런 결정 과정에는 기술만이 아니라 정치가 영향을 미친다.

AI에 대한 국방부의 예산은 2016년 대형 기술 기업들이 투입한 200억~300억 달러와 비교하면 극히 일부다. 아마존과 마이크로소프트가 국방부와의 클라우드 컴퓨팅 계약에 100억 달러 가까이 쓴 것처럼 많은 미국 기업들이 국방비를 부담하는 것을 받아들이고 있다. 그러나 일부 기업들은 마음을 바꾸고 있다. 2018년 6월, 구글은 국방부와 체결한 900만 달러의 프로젝트 메이븐 협업 계약을 연장하지 않기로 했다. 4000명의 직원들이 회사가 “전쟁 기술”에 개입하는 것에 항의한 이후의 결정이었다.

반면 중국에서는 기업들이 국가 서비스에 쉽게 동원될 수 있다. 개인 정보 보호법은 사소한 불편에 가깝다. 지난 6월, 미국 국방부 부장관을 지낸 로버트 워크(Robert Work)는 “데이터가 AI의 연료 역할을 한다고 본다면, 중국은 전 세계에서 가장 큰 구조적 이점을 갖게 되는 것”이라고 경고했다. 민간인의 개인 정보가 군사 알고리즘에 연료 역할을 할 수 있을지는 알 수 없지만, 이 문제는 군 지휘부의 심리에 영향을 줄 수 있다. 8월 30일 잭 섀너한(Jack Shanahan) JAIC 국장은 이렇게 말했다. “우리의 잠재 적국이 AI로 무장한 군대를 보유하고 있는데, 우리는 그렇지 않은 미래는 상상하고 싶지 않다.”

* 관련 콘텐츠를 더 읽고 싶으신가요? 아래 키워드를 클릭해 보세요.

#정치 #안보 #테크 #과학 #AI #데이터 #미국 #중국 #이코노미스트

게임 해볼래?

2018년 12월 딥마인드의 또 다른 프로그램 알파스타(AlphaStar)가 실시간으로 진행되는 비디오게임 스타크래프트II의 강력한 게이머를 격파했다. 바둑처럼 차례차례 진행되는 방식도 아니었고, 상대가 누구인지도 모르는 상태였다. 알파스타는 알파고보다 더 자유롭게 경기에 임했다. 많은 장교들은 이 같은 게임 수행 능력이 군대의 역사에서도 손에 꼽히는 유형의 독창적이고 정교한 군사 훈련으로 이어지기를 바라고 있다. 미 국방부의 상업용 기술 시험 부서인 방어 혁신 본부(the Defence Innovation Unit)의 마이클 브라운(Michael Brown) 국장은 AI가 투입되는 “전략적 추론”이 본부의 최우선 과제 중 하나라고 언급했다.

그러나 인간의 창의성을 뛰어넘은 알고리즘은 인간의 이해 범위를 벗어날 수도 있다. 그렇게 되면 법률, 도덕 그리고 신뢰와 관련된 문제가 생긴다. 전쟁 법률은 민간인 피해와 군사적 이득 사이의 비례 원칙이나 필요성 원칙 같은 개념에 대한 일련의 판단에 따른다. 왜 이 목표물이 선택됐는지 설명하지 못하는 소프트웨어는 법률을 준수하지 못할 것이다. 설사 준수했다 하더라도 사람들은 표면적으로는 ‘마법의 8번 공(질문에 대한 스무 가지 답을 무작위로 보여 주는 장난감)’처럼 보이는 의사 결정 보조 도구의 판단을 믿지 않을 것이다.

영국 공군 정보 사령관 키스 디어(Keith Dear)는 이렇게 묻는다. “AI가 군사 전략에 적용되고, 인간이 고려할 수 있는 작전의 범주를 넘어서서 다중적인 상호 작용에 따른 확률적인 추론을 제시할 때 우리는 어떻게 해야 할까?”, “인간이 이해하지 못하는 행동 방침을 제시한다면 어떻게 할 것인가?” 그는 AI가 루마니아 수도 몰도바에서 일어난 러시아의 군 급습에 대한 대응으로 아제르바이잔의 수도 바쿠에서 열리는 오페라에 후원금을 내라는 제안을 할 수도 있다고 설명했다. 이런 초현실적인 전략은 적군이 아니라 아군을 당황하게 만들 수 있다. AI의 이런 결정은 앞선 정치적 사건들을 바탕으로 도출된 것이지만, 지휘관들이 즉각적으로 받아들일 수 있는 전략은 아니다.

디어는 그러나, 인간이 불가해성과 효율성 사이의 거래를 받아들일 것이라고 전망했다. “오늘날의 기술적인 한계에도 불구하고 AI는 현실에 가까운 거대한 규모의 시뮬레이션을 거쳐 실제 전투의 의사 결정을 도울 겁니다. AI가 전투를 장악하지 않는다면 말이죠.”

말도 안 되는 얘기가 아니다. 리처드 배런 경은 영국 국방부가 이미 현실 세계의 복합적인 환경을 모방한 가상의 클라우드 기반 환경에서 기술을 시연할 수 있는 소프트웨어를 사들이고 있다고 전했다. 이 소프트웨어는 ‘포트나이트’와 같은 온라인 비디오게임을 거대한 스케일로 확대한 군사 버전 게임이라고 할 수 있다. 게임 회사인 임프로버블(Improbable)과 비행 시뮬레이터로 잘 알려진 CAE가 개발했는데, 개방형 표준을 사용하고 있어서 기밀 정보부터 실시간 날씨 데이터까지 모든 정보를 연결할 수 있다. 리처드 경은 방대한 데이터와 그것을 옮길 수 있는 네트워크, 데이터를 처리할 수 있는 클라우드 컴퓨팅이 존재하는 한 “이 소프트웨어는 명령과 통제가 이뤄지는 방식에 혁신을 일으킬 것”이라고 말했다. 새로운 시스템은 “NSC부터 실무 지휘관에 이르는 하나의 종합적인 명령 체계”를 가능하게 만들 것이다.

인간이 없는 자동화

서구 국가들은 AI가 활용되더라도 사람이 기계를 감독하면서 핵심 역할을 할 것이라고 주장하고 있다. 그러나 해당 국가 정부의 관계자들조차 이런 생각에 동의하지 않는다. 디어 사령관은 “인간은 의사 결정 과정에 참여하지 않아 정보에서 배제되거나, 작전부터 전략까지 다양한 의사 결정을 하는 팀에서 축출될 가능성이 커 보인다”고 말했다. 중국 군사 전문가인 엘사 카니아 박사에 따르면, 중국 군사과학원 보고서에도 “전투는 인간의 인지 능력을 뛰어넘는 수준으로 빨라질 것”이라는 내용이 있다. 그 결과는 자율 무기뿐 아니라 자동화된 전쟁터에도 영향을 미칠 것이다. 전쟁의 초기 단계에서 상호 연결된 AI 시스템은 미사일 발사대, 항공 모함 등 목표물을 정하고, 가장 효율적인 순서로 파괴할 수 있는 빠르고 정확한 공격을 실행할 것이다.

이런 변화가 초래할 결과는 여전히 불투명하다. 로렌스 리버모어 국립 연구소의 재커리 데이비스(Zachary Davis) 박사는 빠르고 정확한 공격 가능성은 “기습의 위험에 대한 인지 수준을 높여 (힘의 균형에 의한) 안정성을 훼손할 수 있다”고 지적한다. 그러나 동시에 AI는 기습 공격의 신호를 감지해 공격을 피할 수 있도록 도와주는 역할도 할 수 있다. 반대로 1960년대 베트남 정글에 투입됐던 센서로 무장한 장비들처럼 비용은 비싸고 효과는 없는 실패한 계획이 될 수도 있다. 그럼에도 불구하고, 어떤 권력도 경쟁 세력보다 뒤처지는 위험을 원치 않는다. 그리고 이런 결정 과정에는 기술만이 아니라 정치가 영향을 미친다.

AI에 대한 국방부의 예산은 2016년 대형 기술 기업들이 투입한 200억~300억 달러와 비교하면 극히 일부다. 아마존과 마이크로소프트가 국방부와의 클라우드 컴퓨팅 계약에 100억 달러 가까이 쓴 것처럼 많은 미국 기업들이 국방비를 부담하는 것을 받아들이고 있다. 그러나 일부 기업들은 마음을 바꾸고 있다. 2018년 6월, 구글은 국방부와 체결한 900만 달러의 프로젝트 메이븐 협업 계약을 연장하지 않기로 했다. 4000명의 직원들이 회사가 “전쟁 기술”에 개입하는 것에 항의한 이후의 결정이었다.

반면 중국에서는 기업들이 국가 서비스에 쉽게 동원될 수 있다. 개인 정보 보호법은 사소한 불편에 가깝다. 지난 6월, 미국 국방부 부장관을 지낸 로버트 워크(Robert Work)는 “데이터가 AI의 연료 역할을 한다고 본다면, 중국은 전 세계에서 가장 큰 구조적 이점을 갖게 되는 것”이라고 경고했다. 민간인의 개인 정보가 군사 알고리즘에 연료 역할을 할 수 있을지는 알 수 없지만, 이 문제는 군 지휘부의 심리에 영향을 줄 수 있다. 8월 30일 잭 섀너한(Jack Shanahan) JAIC 국장은 이렇게 말했다. “우리의 잠재 적국이 AI로 무장한 군대를 보유하고 있는데, 우리는 그렇지 않은 미래는 상상하고 싶지 않다.”

* 관련 콘텐츠를 더 읽고 싶으신가요? 아래 키워드를 클릭해 보세요.

#정치 #안보 #테크 #과학 #AI #데이터 #미국 #중국 #이코노미스트

[1]

1968년 1월부터 1973년 2월까지 베트남 전쟁 중에 수행된 미국의 합동 군사 전자전 작전

[2]

사용 장비와 기후 등 표준 상태에서의 사격 제원과 조건이 변했을 때 변화량을 표시한 도표